使用 LM Studio 本地部署 LLM

使用 LM Studio 本地部署 LLM

Mitchell准备工作

你需要一台运行有 Windows、macOS 或 Linux 的电脑。考虑到 LLM 的生成速度,建议至少是台配备 NVIDIA 独立显卡的电脑,或是 Apple Silicon (M系列处理器) 的 Mac 电脑。

本地部署LLM - 以DeepSeek R1蒸馏版本为例

这里推荐使用 LM Studio 进行本地部署。相较于 Ollama,LM Studio 具有友好的 UI 界面,更丰富的功能集和更大的模型库。

如果你想尝试使用 Ollama 部署,可以参考这个教程:53AI知识库 - 本地部署大模型?看这篇就够了,Ollama 部署和实战

下载LM Studio

根据电脑的系统和处理器架构选择合适的版本下载:

下载 LM Studio安装LM Studio

按照提示,安装即可。

下载适合的模型版本

点击搜索按钮:

搜索 DeepSeek R1 Distill(对于Mac电脑,建议在搜索框右侧取消勾选GGUF,仅勾选MLX):

考虑到下载时间可能比较长,可以从其他方式下载 DeepSeek-R1-Distill-Qwen-7B 的 GGUF 或 MLX 格式模型的离线文件,将文件移动到模型存放目录即可。模型存放目录可通过以下方式打开:

点击 My Models:

点击“…” → Open in File Explorer:

加载模型

点击 Developer:

启动本地服务:

点击加载模型。选择合适的模型,如果出现下面的选项框,无需改动直接 Load Model 即可:

然后就可以新建对话,在 LM Studio 中测试对话了。

本地LLM的简单应用

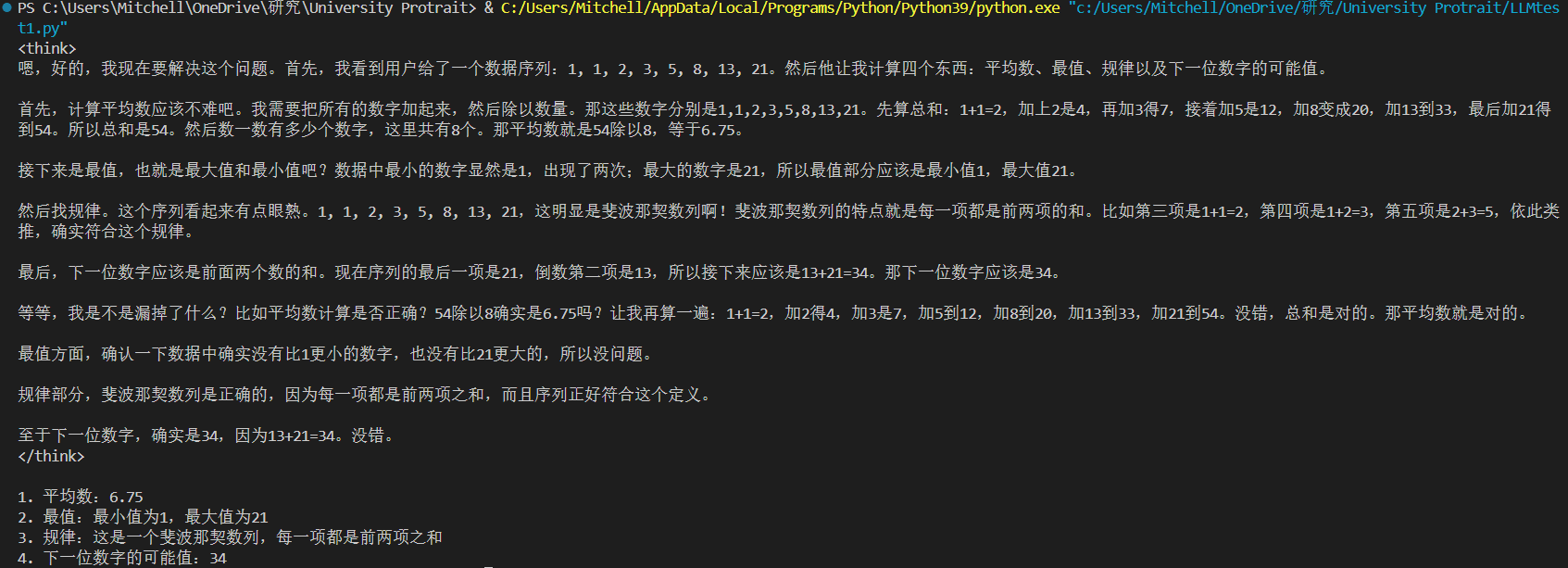

这里准备了一段实例代码,让部署在本地的 DeepSeek-R1-Distill-Qwen-7B 做一些简单的数据分析任务,并且根据它的知识库猜一猜所给数字的可能规律,以及预测下一位数字。

1 | # LLMtest.py |

运行结果如下:

评论

匿名评论隐私政策

✅ 你无需删除空行,直接评论以获取最佳展示效果